Здравствуй, дорогой читатель. Сегодня поговорим о важнейшем инструменте индексации интернет ресурса — файле robots.txt- файл для сайта wordpress.

Вновь созданной публикации блога на пути к читателю необходимо пройти этап индексации. От этого зависит ее дальнейшее ранжирование и успех. В нашем распоряжении при работе с wordpress сайтом два инструмента управления данным процессом. Первый — это xml-файл sitemap. Данный инструмент помогает роботам ориентироваться на сайте и быстро находить новую информацию. Подробнее о нем и его создании на сайте — в отдельной статье. Второй, не менее важный инструмент — файл robots.txt. Сегодня поговорим о том, для чего он служит, как его создать для своего сайта, проверить на ошибки и разместить на своем ресурсе.

Содержание

Файл robots.txt — что это и зачем нужен

Robots.txt — это рекомендации по обработке информации на сайте для индексирующих поисковых роботов.

Определенными директивами файл не рекомендует им индексировать названые страницы. Также указывает на сканирование нужных. В том числе включает информацию об адресах главного зеркала сайта и его карте.

Зачем же с его помощью запрещать сканирование страницы ресурса?

В силу своего назначения ряд страниц являются техническими. Они имеют специфическую, не оптимизированную информацию, часто в очень малом количестве. Их индексация отрицательно повлияет на ранжирование сайта. А демонстрация содержимого не представляет интереса для обычных читателей.

Например, это страницы авторизации, смены пароля, результатов внутреннего поиска по сайту, страницы-дубли и версии страниц для печати, временные страницы, а также с личными данными посетителей, страница с корзиной и другие.

При отсутствии на сайте файла robots.txt или при отсутствии в нем запрета на чтение технических страниц боты будут беспорядочно по нему ходить и собирать для анализа всю информацию подряд. Если они аккуратно переберут корзину с удаленными материалами, то решат, что сайт не структурирован, содержит нетематический контент и похож на мусорное ведро.

Или. Для каждого медиафайла в вашей статье создается отдельная техническая страница. Она содержит только его. Поэтому является почти пустой, совсем неоптимизированной и непонятной для сканирующих программ. И таких страниц на сайте много. Если боты их проанализируют, то решат, что сайт состоит из пустых страниц. О том, что это плохо для ресурса, вы уже понимаете. Поэтому с помощью данного файла возможно показывать поисковым роботам только необходимый контент для формирования о сайте хорошего мнения.

Мы разобрались, что такое файл robots.txt и чем он нам полезен. Теперь о том, как его создать, проверить и разместить на сайте.

Как создать robots.txt для wordpress сайта самому

Так как robots.txt — текстовый файл, его можно составить в Блокноте. Файл рекомендуется именовать именно «robots.txt». Он регистрозависимый. То есть его содержание и наименование чувствительны к прописным и строчным символам.

Содержание файла состоит из строчных записей. Каждая строка начинается с директивы, написанной с большой буквы. Может содержать одну директиву и один параметр.

Строки объединяются в группы. Каждая из которых начинается директивой «User-agent» и адресована к роботам определенной системы. Внутри группы пропущенные строки не допускаются.

Директивы robots.txt

User-agen

Данная директива содержит имя робота, для которого составлены предписания. Обращение ко всем ботам выглядит так: «User-agent:*». А к роботу конкретной системы так: «User-agent: Yandex».

Кроме роботов поисковых систем сайт, могут посещать различные вредоносные парсеры. Они действуют как поисковые. Поэтому для них также можно прописать запрещающие правила.

Disallow / Allow

Директива Disallow запрещает обход указанных разделов или страниц. Адрес закрытой страницы указывается после слэша. Молодой сайт на стадии отсутствия контента можно закрыть от индексации следующим образом.

Однако WordPress имеет и свой встроенный инструмент для закрытия сайта от индексации.

Allow — разрешающая директива. Например, командой «Allow: */uploads» открываем папку с файлами uploads, предназначенных читателям. Или (не рекомендуется) открываем следующими строками для индексирования весь сайт, что равносильно отсутствию данного файла на нем.

Так открываем для индексации один раздел «Статьи», все остальные страницы при этом закрыты.

При одновременном использовании директив Disallow и Allow приоритетной является с более длинным путем. В случае одинаковой адресации предпочтение будет отдано строке Allow.

Sitemap

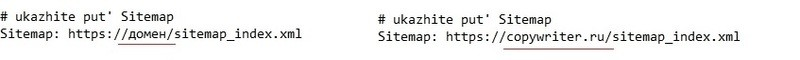

Директива Sitemap объявляет путь к карте сайта. Эта строка обычно размещается в конце файла. О функциях и создании карты сайта — в отдельной статье. А прописываем ее так.

Crawl-Delay

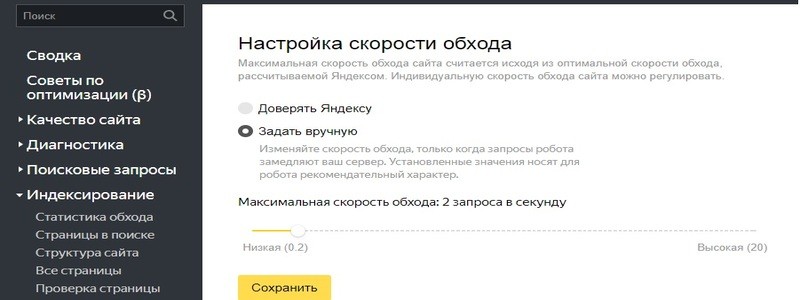

Директива Crawl-Delay ранее ограничивала или увеличивала частоту посещений вашего сайта поисковым роботом Яндекс. Однако в настоящее время Яндекс заменил ее инструментом «Скорость обхода» (в разделе «Индексирование») в сервисе Яндекс Вебмастер. На соответствующей вкладке включаем команду «Задать вручную» и передвигаем ползунок в нужное положение. Сохраняем изменения.

Clean-param

Директива Clean-param сообщает ботам, что адрес страницы содержит элементы (GET-параметры или UTM-метки), которые не нужно учитывать при индексации. Например, она рекомендует роботу основной адрес среди страниц-дублей. Они могут появляться при продвижении сайта через контекстную рекламу. При этом оформленная директива сможет передать основной странице накопленные показатели и снизить нагрузку на сайт. Подробнее о том, как оформить эту директиву для ботов Яндекс.

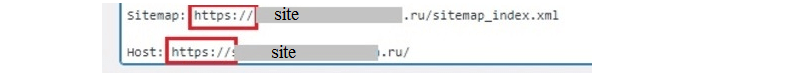

Host

Директива Host сегодня не обязательна. Но если присутствует в файле robots.txt, то должна содержать адрес главного зеркала сайта с буквой «s» в https. Это указание поисковым системам, какой сайт считать основным. Данная строка обычно бывает последней в файле.

Синтаксис robots.txt

При составлении файла robots.txt используются определенные обозначения.

Двоеточие «:» используется только после директивы, а также в адресах карты сайта и его главного зеркала.

Звездочка «*» — это маска, обозначающая обязательное для всех правило. Если имеется уточнение правила, то оно будет расположено далее в строке.

Слэш «/» можно ставить после директивы с двоеточием, перед названием файла, страницы, раздела. Если раздел нужно закрыть, то после него также допустимо поставить слэш. В ряде случаев пропуск слэша может изменить указание директории на противоположное.

Доллар «$» — ограничивает действие правила адресом страницы, после которой установлен.

За решеткой «#» возможно разместить комментарий для разработчика, который пропускается роботами. Нельзя его размещать внутри строки директории. Пишем только после правила.

Название разделов и файлов должны упоминаться только на латинице. Для конвертирования кириллицы в латиницу можно использовать специальные интернет сервисы. Или установить на сайте плагин с функцией транслита типа Clearfy и копировать готовые адреса нужных страниц с сайта.

Недопустимо ставить пробел перед директивой, применять кавычки и символ «;».

Правила robots.txt

Яндекс устанавливает правила для файла robots.txt с целью его правильной обработки роботами. Он должен быть на сайте в единственном числе. Иметь название «robots» и расширение «.txt». Размер файла не должен превышать 500 КБ. А размещать его необходимо в корневом каталоге ресурса.

Пример robots.txt для wordpress сайта

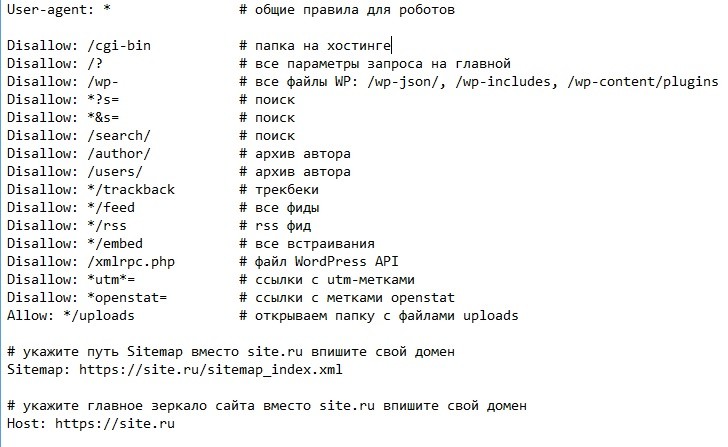

Мы познакомились с правилами создания файла robots.txt для wordpress сайта. Вы можете теперь сами его написать. В качестве примера размещу возможное его содержание с комментариями.

Проверка robots.txt

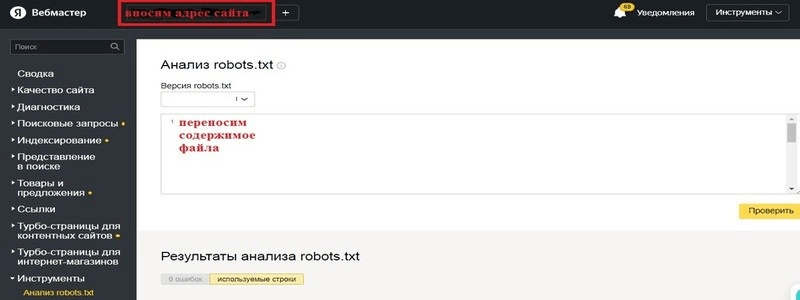

Данный файл можно проверить на ошибки с помощью сервиса Яндекс Вебмастер. Для этого открываем раздел «Инструменты» и переходим в подраздел «Анализ robots.txt». В строку «Ресурс» вносим адрес сайта. Вставляем содержимое файла в тестовое поле ниже. Далее нажимаем кнопку «Проверить».

После проверки в «Результатах анализа» сервис покажет количество ошибок в файле или их отсутствие. Ошибки исправляем, а файл заново проверяем.

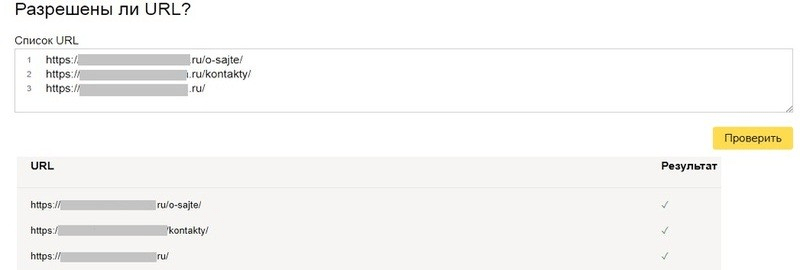

На странице ниже находим раздел «Разрешены ли URL». Он позволяет проверить доступ к отдельным страницам. В окно вносим адрес нужной страницы и нажимаем «Проверить». Ниже появится результат. У страницы с разрешением на индексирование напротив ее адреса будет стоять галочка. При выявлении веб-страниц с ошибочным запретом на сканирование необходимо внести исправление в файл robots.txt.

Как добавить на сайт robots.txt

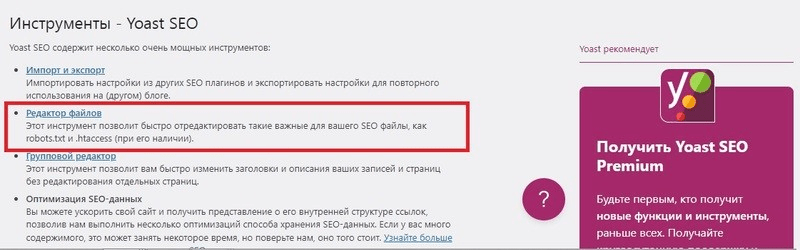

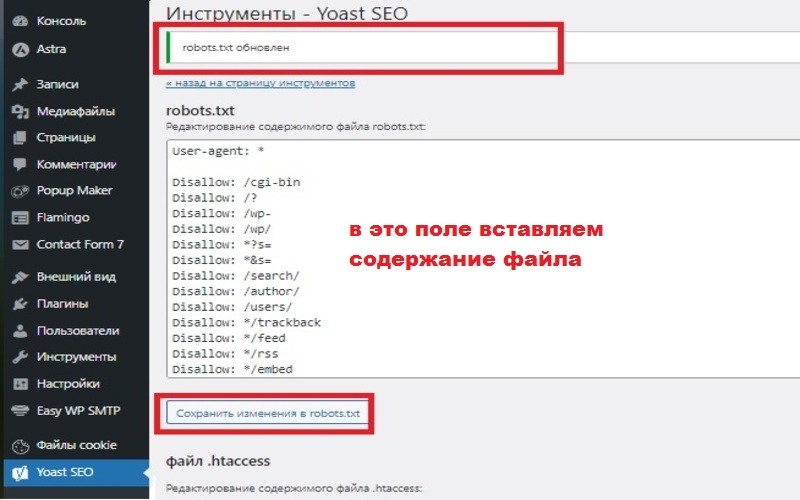

Для загрузки на сайт готового файла robots.txt проще использовать установленный плагин Yoast SEO. Тогда в административной панели появляется раздел «Yoast SEO». Из него в подраздел «Инструменты». Находим и нажимаем строку «Редактор файлов».

В следующем окне будут доступны для редактирования поля двух файлов: htaccess и robots.

Внимание.

Поле файла robots.txt не перепутайте с полем файла .htaccess !

Входим в поле под строкой «Редактирование содержимого файла robots.txt». Удаляем имеющийся шаблон. Копируем содержание своего файла и вставляем его в очищенное поле. Нажимаем кнопку «Сохранить изменения в robots.txt» под полем его размещения. После этого появится сообщение «robots.txt» обновлен».

Возможна загрузка и без использования плагинов. Через административную панель хостинга. Для этого на хостинге в панели управления переходим в раздел «Файловый менеджер» и загружаем файл в корневую папку.

Заключение

Сегодня рассмотрели основные команды и правила создания файла robots.txt для сайта wordpress. А так же способы проверки правильности его составления и размещения на своем ресурсе. Это важный элемент любого сайта, задающий параметры его индексирования и влияющий на его ранжирование. Поэтому обязательно сделайте его и закройте от индексирования все технические страницы.

Правильно работающий файл sitemap.xml вместе с robots.txt организует быстрое сканирование сайта «полезными» ботами. Для закрытия входа «плохим» роботам подкорректируйте .htaccess и организуйте защиту страницы авторизации в админке.